Entradas del autor

Jun 25 2024

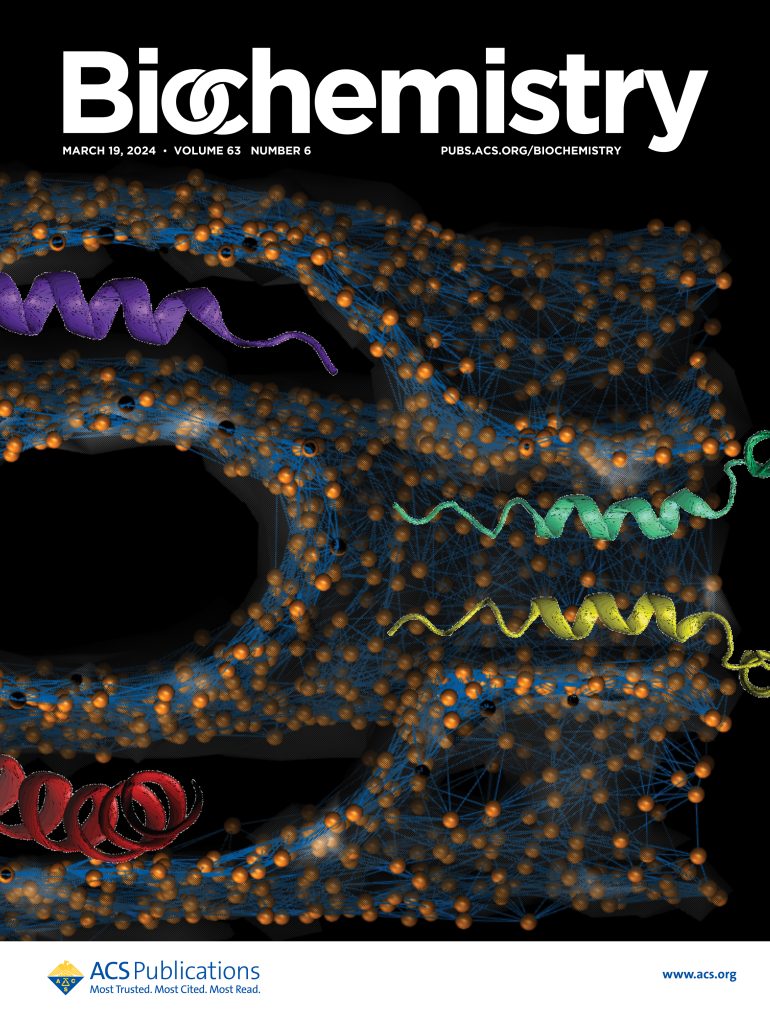

Seminario “Cómo correr AlphaFold 2 en Mendieta F2”

El CCAD ofrece el Seminario “Cómo correr AlphaFold2 en MendietaF2” Online, Libre y Gratuito Dictado por: Álvaro Schachner (FaMAF-UNC) y Juan Ignacio Folco (Ingeniería-UCC) Viernes 28/6, 10 a 11.30 hs https://meet.google.com/gsq-tcbc-msd

Abr 05 2024

«Carpinchos» viaja a China para competencia internacional.

La semana del 8 de abril se desarrollará la onceava edición de la competenciaStudent Supercomputer Challenge de Asia Supercomputing en el marco de ASC24 AsiaSupercomputing. El equipo Carpinchos del Centro de Computación de Alto Desempeño (CCAD)de la UNC clasificó para la final quedando entre los 25 mejores de más de 300equipos de todo el mundo. …

Dic 13 2023

Desentrañar el ADN de las poblaciones argentinas: el CCAD participa de PoblAr

El Centro de Computación de Alto Desempeño de la UNC colabora en el procesamiento de datos genómicos recolectados en diversos puntos del territorio argentino, con el fin de constituir el primer biobanco del país. Desde la conquista de América y el establecimiento de colonias en el continente, se inició un proceso de mestizaje entre las …

Oct 23 2023

UNITEFA conforma la primera comunidad del Proyecto Catalyst en la UNC, a través del CCAD.

A partir de una colaboración académica se podrá acceder a cómputo interactivo en la nube y esto permite utilizar técnicas avanzadas de procesamiento de datos aplicados al desarrollo de las Ciencias Farmacéuticas. Desde hace algunos meses, el Centro de Computación de Alto Desempeño (CCAD, UNC) participa de Catalyst Project, un proyecto que busca crear …

Oct 11 2023

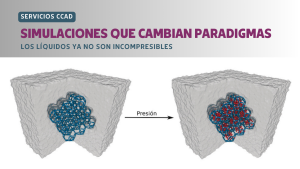

SIMULACIONES QUE CAMBIAN PARADIGMAS: los líquidos ya no son incompresibles

Investigadores del Instituto Interdisciplinario de Ciencias Básicas (ICB, CONICET-UNCUYO), usando simulaciones realizadas en el CCAD, participaron de un trabajo internacional que creó líquidos con alta compresibilidad. «La compresibilidad es la capacidad que tiene un material de cambiar su volumen ante un cambio de presión, y que da origen a aplicaciones tecnológicas en neumática e hidráulica. …

Sep 29 2023

El CCAD participó de CARLA 2023

Durante la décima edición de la Conferencia Latinoamericana de HPC, miembros del CCAD participaron como disertantes en un workshop, dictando un tutorial y asistiendo a las diversas actividades que se ofrecieron en Colombia entre el 18 y el 22 de septiembre. Los CPA del Centro de Computación de Alto Desempeño, Marcos Mazzini y Alejandro Silva, …

Sep 15 2023

El CCAD se hizo presente en el 15° Coloquio Industrial de Córdoba

El evento organizado por la Unión Industrial de Córdoba tuvo lugar el pasado 14 de septiembre y posibilitó el intercambio y discusión entre el sector privado, el público y el académico. El Centro de Computación de Alto Desempeño (CCAD) de la UNC, participó en una nueva entrega del evento más importante del sector industrial de …

Ago 16 2023

HPC: inversión y soberanía

Federico Stasyszyn y Dante Paz, miembros del Directorio del CCAD, participaron en una entrevista en el podcast “El Bestiario de Internet”, de Fundación Vía Libre, y conversaron acerca de la importancia y dificultades de lograr una soberanía de cómputo. Durante una distendida charla, Federico Stasyszyn y Dante Paz, miembros del Directorio del Centro de Computación …

Jul 07 2023

El CCAD en una competencia Internacional

Un equipo integrado por miembros del CCAD, estudiantes de la Facultad de Matemática, Astronomía y Física (FaMAF, UNC) y de la Facultad de Ingeniería (UCC), fue admitido para formar parte de la IndySCC. La IndySCC es un evento que comparte los objetivos del SCC pero con énfasis en educación e inclusión, dirigido especialmente para equipos …

Jun 30 2023

Taller Usando Jupyter en CCAD

El miércoles 5 de julio, a las 10 h, el CCAD brindará un Taller sobre el uso de Jupyter: Julia, Python, R Oscar Reula y Juan Perotti, ambos miembros del CCAD, brindarán el Taller Usando Jupyter en CCAD, el día miércoles 5 de julio a las 10 h, con modalidad mixta. Se dictará de manera …