Entradas del autor

Sep 06 2023

Artículo de tapa en Nature con cómputo en CCAD

El paleontólogo Martín Ezcurra corrió análisis de filogenia en las computadoras del CCAD para un artículo que terminó publicado en la tapa de la revista Nature del 17 de agosto de 2023. En septiembre de 2022 el Paleontólogo Martín Ezcurra nos escribía: «Estimado Nicolás Wolovick: soy Martín Ezcurra, paleontólogo del CONICET-Museo Argentino de Ciencias Naturales …

Ago 23 2023

Serafín fue refrescada en hardware y software

Una falla de fabricación de los chips de RAM de Serafín derivó en un recambio por parte del fabricante de más del 70% de la memoria. En estos 43 nodos la memoria pasó de 128 GiB a 256 GiB. Se aprovechó la parada total para hacer una actualización de software completa. «Uncorrectable ECC» En febrero …

Jul 03 2023

Acelerando un código de simulación de crecimiento de tumores

Jerónimo Fotinós y su director Lucas Barberis, están trabajando sobre simulaciones de crecimiento de tumores cancerígenos in vitro. Dentro de su doctorado Jerónimo pasó el código de 2D a 3D y se encontró con que necesitaba una gran cantidad de cómputo. Carlos Bederián, CPA Principal del CCAD, aportó su experiencia y aceleró el código por …

May 15 2023

Serafín suma un Nodo de Cómputo Interactivo

Serafín suma un nuevo nodo de Cómputo Interactivo. Este permitirá a las y los usuarios del CCAD, con la misma cuenta, realizar limpieza, análisis y visualización de datos, asi como cómputo liviano, utilizando las tecnologías de environments y Notebooks. El rack central de Serafín tiene un nuevo nodo con características peculiares: CPU: AMD Ryzen Threadripper …

May 10 2023

Todo el poder de AMD CDNA2 en el CCAD

AMD Latinoamérica reconoce el liderazgo y la capacidad técnica del CCAD donando dos aceleradoras Instinct MI210, con tecnología CDNA2, la misma que usa Frontier, la supercomputadora #1 del mundo. La primera de las dos aceleradoras MI210 llegó al CCAD. Este monstruo PCIe 4.0 16x consume 300W y tiene unas especificaciones a la altura de su …

Mar 14 2023

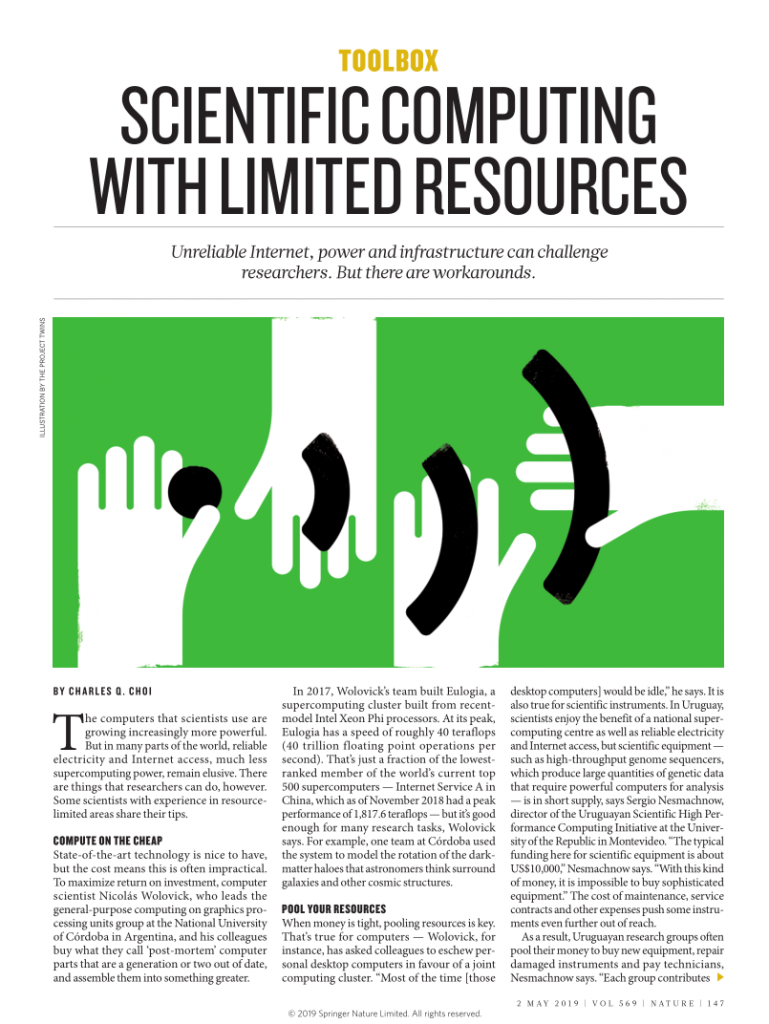

Mulatona y Eulogia reinstaladas con software nuevo

Actualizamos los clusters más viejos con el software más nuevo posible. Una segunda y última vida a Mulatona y Eulogia, que gracias a las actualizaciones mejoraron su desempeño en aplicaciones muy usadas como Quantum Espresso. Mulatona y Eulogia son nuestros clusters más viejos. Mulatona es algo asi como modelo 2016 y Eulogia 2018. Teniendo en …

Mar 08 2023

Compras de fin de año

En el CCAD no le decimos que no a nada, y a fin de año hicimos un llamado para aprovechar los restos de proyectos PICT o SeCyT-UNC. Cerraba diciembre y ya casi sin aliento pegamos el último empujón antes de que se terminara todo. Convocamos a las usuarias y usuarios del CCAD que tuvieran algún …

Feb 24 2023

Donación de Mercado Libre oficina Córdoba

La oficina Córdoba de Mercado Libre se comunicó con el Prosecretario de Informática de la UNC para contarle que tenían hardware ocioso. El CCAD tomó este ofrecimiento y se hizo de servers, firewalls y un NAS. Tres servers Dell R720, dos firewalls Palo Alto PA-3020 y un NAS NetApp DS4246 fue el resultado de una …

Dic 28 2022

Diez Milan y ocho A10 para CCT-Rosario

Con fondos de la Provincia de Santa Fé, el CCT-Rosario compra equipamiento de HPC. Dos servidores ultradensos uno de CPU y otro de GPU, más un switch Infiniband conforman este combo que se suma al cómputo de CyT de Santa Fé. Casi al finalizar el año, llegaron al CCT-Rosario, los equipos que se obtuvieron del …

Nov 22 2022

Más GPUs para MendietaF2

Mendieta Fase 2, es la supercomputadora más vieja y más nueva del CCAD. Utilizando equipos end-of-life como base, los remozamos con placas GPU NVIDIA Ampere. Pasamos de 14 placas funcionando a 24 y en breve a 26. Las 11 placas nuevas para MendietaF2 que costaron más de 38.000 dólares estadounidenses, surgen del aporte de tres …