Se continua con el proceso de renovación de las y los representantes en el Centro de Computación de Alto Desempeño de la UNC. En este caso la Facultad de Ciencias Exactas, Físicas y Naturales, nombró por primera vez a sus representantes para integrar el Directorio del CCAD. Como titular asumió Nehuen Gonzalez Montoro y como suplente, …

Archivo de diciembre de 2022

Dic 28 2022

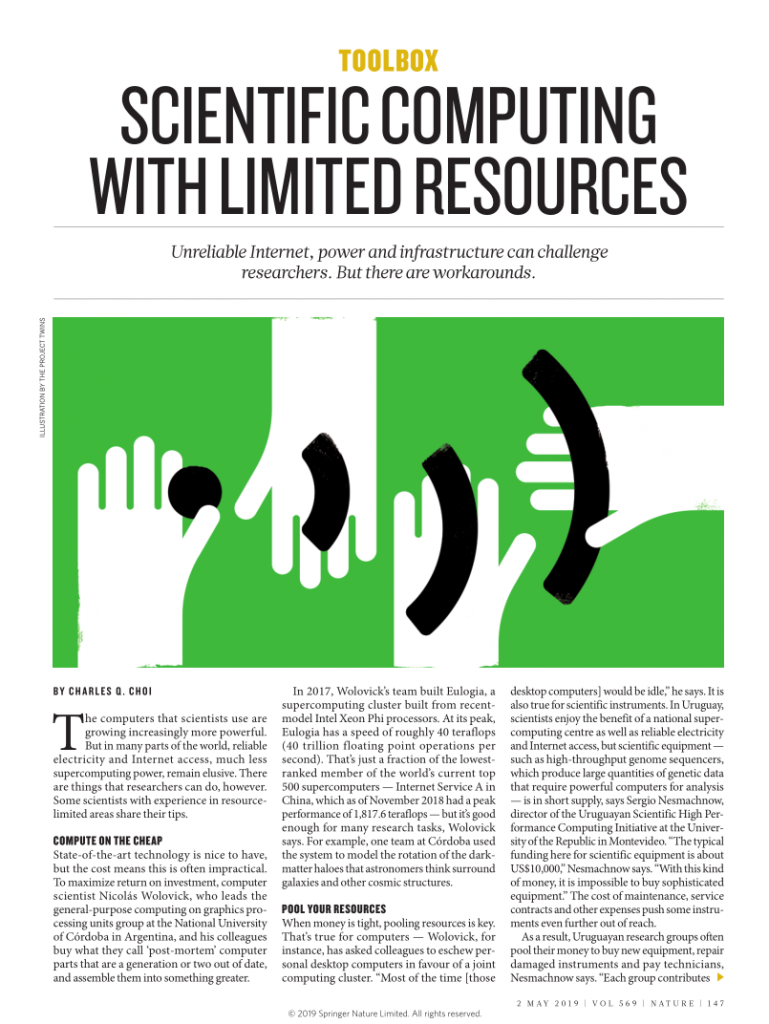

Diez Milan y ocho A10 para CCT-Rosario

Con fondos de la Provincia de Santa Fé, el CCT-Rosario compra equipamiento de HPC. Dos servidores ultradensos uno de CPU y otro de GPU, más un switch Infiniband conforman este combo que se suma al cómputo de CyT de Santa Fé. Casi al finalizar el año, llegaron al CCT-Rosario, los equipos que se obtuvieron del …

Dic 22 2022

Conocer la diversidad genética de las antiguas poblaciones pampeanas a través de Mendieta

Angelina García -investigadora- y Nicolás Pastor -personal de apoyo- del IDACOR (CONICET-UNC), emplean los recursos del CCAD para estudiar la variabilidad genética de diferentes poblaciones humanas de Argentina. El sur de la región pampeana de nuestro país fue uno de los primeros espacios geográficos en ser ocupados en el continente americano. Sin embargo, la dinámica …

Dic 21 2022

CCAD UX: Experiencia como usuario del CCAD

Finalmente después de 5 años de desarrollo pudimos enviar a una revista nuestro trabajo titulado: «Guess the cheese flavour by the size of its holes: A cosmological test using the abundance of Popcorn voids«. El 13 de Diciembre del 2022 al mismo tiempo que el árbitro pitaba el comienzo del partido entre Argentina y Croacia, …