La primer etapa del mismo entró en funcionamiento el 7 de Mayo de 2013 con fondos aportados por la Facultad de Matemática, Astronomía y Física (FaMAF) de la Universidad Nacional de Córdoba (UNC), y los Instituto de Física Enrique Gaviola (IFEG) e Instituto de Astronomía Teórico y Experimental (IATE), dependientes del CONICET.

La segunda etapa licitada y adjudicada por el Centro de Computación de Alto Desempeño (CCAD) de la UNC, con fondos provenientes del Sistema Nacional de Computación de Alto Desempeño (SNCAD) del Ministerio de Ciencia y Tecnología, fue puesta en funcionamiento el 6 de Junio de 2014.

Configuración de Hardware

Primera Etapa, 8 nodos con:

- 2 procesadores Intel Xeon E5-2680 de 8 cores cada uno a 2.7 GHz.

- 64 GiB DDR3 a 1333 MHz.

Segunda Etapa, 14 nodos con:

- 2 procesadores Intel Xeon E5-2680 v2 de 10 cores cada uno a 2.8 GHz.

- 64 GiB DDR3 a 1600 MHz.

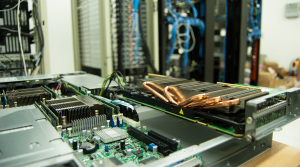

Aceleradoras

-

12 aceleradoras NVIDIA Tesla M2090 con 6 GiB de memoria GDDR5.

-

8 aceleradoras NVIDIA Tesla K20x con 6 GiB de memoria GDDR5.

-

14 aceleradoras Intel Xeon Phi 31S1P, con 8 GiB de memoria GDDR5 configuradas en modo nativo.

Almacenamiento y Conectividad

- NAS de 26 TiB de capacidad con conectividad Infiniband dentro de un chasis de 9U Chenbro RM91250 con dos Xeon E5-2620v3 y 64 GiB de RAM.

-

Conectividad Infiniband QDR y doble Gigabit Ethernet (parte del NFS, administración).

-

Switch Infiniband Mellanox MTS3600R de 36 puertos.

Desempeño

Tomando en cuenta los Rpeak individuales en doble precisión: Xeon E5-2680 173 GFLOPS, Xeon E5-2680 v2 224 GFLOPS, Tesla M2090 666 GFLOPS, Tesla K20x 1170 GFLOPS y las Xeon Phi 31S1P 1003.2 GFLOPS, la performance pico teórica de todo el cluster alcanza los 40.436 TFLOPS siendo la segunda de la Argentina a octubre 2016.

El 25 de Septiembre de 2014 se corrió High Performance Linpack (HPL) y se logró un Rmax de 14.79 TFLOPS, utilizando solamente los 14 nodos de la Segunda Etapa y todas las aceleradoras Tesla.

Software instalado

- CentOS 6.8.

- Warewulf 3.6.

- SLURM 14.03.8.

- Environment modules 3.2.10.

- Compiladores: gcc-{4.6.4, 4.7.3, 4.8.2, 4.8.3, 4.9.2}, nvcc-{5.0, 5.5, 6.0, 6.5, 7.0}, pgi-12.8, intel-{2013, 2014}, ghc-7.6.3.

- Bibliotecas: fftw-{2.1.5, 3.3.3, 3.3.4}, magma-1.3.0, openblas-{0.2.8, 0.2.11, 0.2.14}, mvapich2-{1.9, 2.0, 2.1}, openmpi-{1.8.1, 1.8.3, 1.8.4, 1.8.4}, petsc-20130502, tbb-{4.1, 4.2, 4.3}, plasma-2.5.0b1.

- Intérpretes/compiladores: python-{2.7.4, 2.7.10}, pycuda-2013.1, mlton-20130715, octave-3.6.4.

- Solvers, simuladores: lammps-15may15, openfoam-{2.3.x, 2.4.0, extend-3.0}, espresso-{20140222, 5.0.3, 5.1, 5.2.1, 5.4.0}, siesta-3.2pl5, gamess-{20130501, 20160211}, gromacs-{4.6.3, 5.0, 5.0.2, 5.0.4, 5.1}.

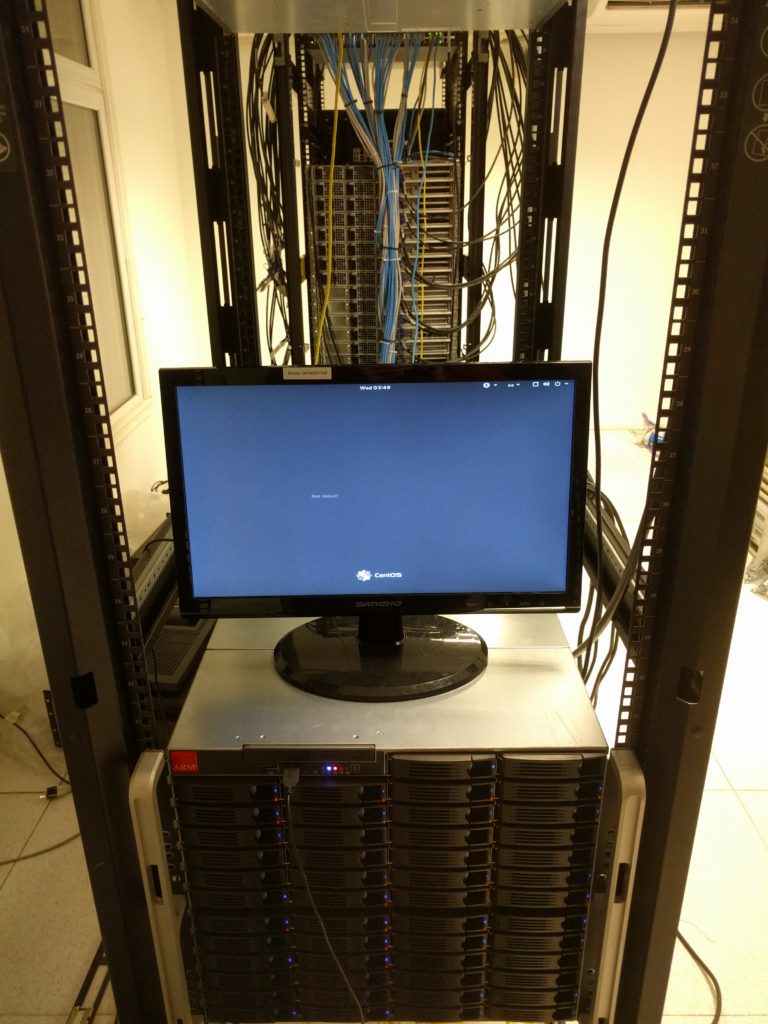

Datacenter

Originalmente el cluster Mendieta estaba emplazada en la Sala de Clusters de EFN-UNC junto al cluster Cristina. En Julio de 2016 se muda junto al NAS a la sala de servidores de la PSI-UNC que dispone de una mejor infraestructura eléctrica y de refrigeración. Los clusters Mendieta y Cristina quedan enlazados por una red de fibra óptica dedicada.

Galería Fotográfica

Galería fotográfica realizada por la Agencia universitaria de comunicación de la ciencia, el arte y la tecnología. Julio 2014 dentro de la Sala de Clusters de EFN-UNC.

Actualización 2017

A partir de una donación de Arris, se agregó el nodo mendieta23 que tiene una configuración de hardware similar a Mendieta Primera etapa, con 2 procesadores Xeon 2670 v1 y 256 GiB de RAM que denominamos fatnode.

Actualización 2018-2019

Los nodos mendieta22 (2018) y mendieta21 (2019) fueron reconvertidos a nodos de cómputo para AI y renombrados como Nabucodonosor. En este momento Mendieta cuenta con 8 nodos de la primera etapa, 12 nodos de la segunda etapa y 1 fatnode. Mendieta está en EOL ya que se cumplieron 7 años desde su puesta en marcha y en HPC se estima una tiempo de 5 años de vida para equipos en base a procesadores estándar.