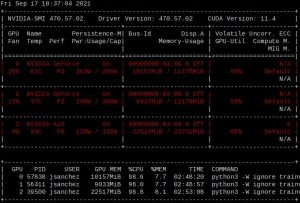

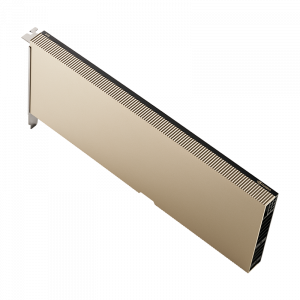

Cuando supimos que obtuvimos el subsidio PFI2021 por $6.000.000, rápidamente adquirimos una placa NVIDIA A10 para probarla en un nodo de Mendieta para ver que todo estuviera ok antes de comprar 21 placas más. Los nodos de Mendieta fase 2 son Supermicro 1027GR-TSF. Unos servidores dual Xeon 2680 v2, con lugar para poner 3 GPUs …

Archivo de septiembre de 2021

Sep 15 2021

Objetos, historias e instituciones. El Balde.

«… tengo grabada la imagen cuando con la camiseta de la selección y balde en mano (se refiere a Antonio Russo) limpiaron la salita de Ingeniería … un Charly contagiado de entusiasmo estaba allí …» El verano de 2016 fue casi tan difícil como el del 2015 en cuanto a lluvias estivales en Córdoba. En …

Sep 14 2021

Con un puñado de usuarios, se llenó Serafín

A poco de abrirse Serafín en beta-test, un puñado de usuarios llenó el cluster de trabajos, muchos de ellos de una cantidad grande de nodos. Lo que esperábamos se cumplió. Aunque Serafín tiene 3x más capacidad que todos nuestros clusters anteriores, se necesita más, mucho más. Mostramos quienes fueron, que hacen y que sensación tuvieron. …

Sep 04 2021

El CCAD obtuvo un PFI por $6M para actualizar Mendieta para ML y MD

El CCAD-UNC con el apoyo del Córdoba Technology Cluster y el CEPROCOR, logró un subsidio de 6.000.000 de pesos para modernizar Mendieta con GPUs de última generación y mejorar las prestaciones para aprendizaje automático (ML) y dinámica molecular (MD). Cuando a fines de mayo Carlos Bederián apuntó a los Proyectos Federales de Inversión 2021 (PFI) …