A partir de una colaboración académica se podrá acceder a cómputo interactivo en la nube y esto permite utilizar técnicas avanzadas de procesamiento de datos aplicados al desarrollo de las Ciencias Farmacéuticas. Desde hace algunos meses, el Centro de Computación de Alto Desempeño (CCAD, UNC) participa de Catalyst Project, un proyecto que busca crear …

Oct 14 2023

Marcos Mazzini expuso sobre Clementina XXI

Agrupaciones estudiantiles de UNC y UNLP organizaron una charla para conocer más sobre la supercomputadora Clementina Siglo XXI recientemente inaugurada. Nuestro CPA, el Lic. Marcos Mazzini estuvo contando sobre las características del primer TOP500 de la Argentina. ¿Qué es, cómo funciona y para qué se va a usar un TOP500 en Argentina? Durante una hora, …

Oct 11 2023

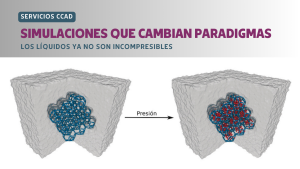

SIMULACIONES QUE CAMBIAN PARADIGMAS: los líquidos ya no son incompresibles

Investigadores del Instituto Interdisciplinario de Ciencias Básicas (ICB, CONICET-UNCUYO), usando simulaciones realizadas en el CCAD, participaron de un trabajo internacional que creó líquidos con alta compresibilidad. «La compresibilidad es la capacidad que tiene un material de cambiar su volumen ante un cambio de presión, y que da origen a aplicaciones tecnológicas en neumática e hidráulica. …

Sep 29 2023

El CCAD participó de CARLA 2023

Durante la décima edición de la Conferencia Latinoamericana de HPC, miembros del CCAD participaron como disertantes en un workshop, dictando un tutorial y asistiendo a las diversas actividades que se ofrecieron en Colombia entre el 18 y el 22 de septiembre. Los CPA del Centro de Computación de Alto Desempeño, Marcos Mazzini y Alejandro Silva, …

Sep 15 2023

El CCAD se hizo presente en el 15° Coloquio Industrial de Córdoba

El evento organizado por la Unión Industrial de Córdoba tuvo lugar el pasado 14 de septiembre y posibilitó el intercambio y discusión entre el sector privado, el público y el académico. El Centro de Computación de Alto Desempeño (CCAD) de la UNC, participó en una nueva entrega del evento más importante del sector industrial de …

Sep 11 2023

Alejandro Silva participa de Escuela de HPC en Barranquilla

El prestigioso ICTP de Trieste apuesta a diversificar geográficamente la formación de recursos humanos en tecnologías, fundamentos y prácticas para el desarrollo científico. Alejandro Silva, CPA CONICET con lugar de trabajo en CCAD, fue becado y está participando de esta Escuela. El ICTP (International Center for Theoretical Physics) es un instituto que promueve la ciencia …

Sep 06 2023

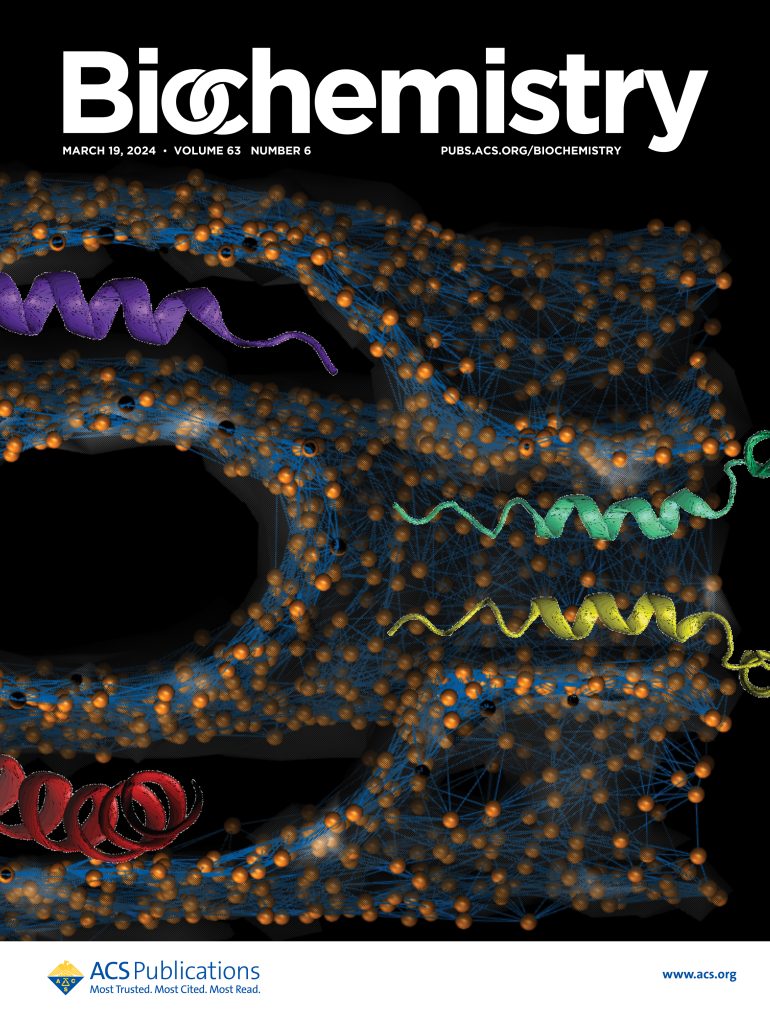

Artículo de tapa en Nature con cómputo en CCAD

El paleontólogo Martín Ezcurra corrió análisis de filogenia en las computadoras del CCAD para un artículo que terminó publicado en la tapa de la revista Nature del 17 de agosto de 2023. En septiembre de 2022 el Paleontólogo Martín Ezcurra nos escribía: «Estimado Nicolás Wolovick: soy Martín Ezcurra, paleontólogo del CONICET-Museo Argentino de Ciencias Naturales …

Ago 23 2023

Serafín fue refrescada en hardware y software

Una falla de fabricación de los chips de RAM de Serafín derivó en un recambio por parte del fabricante de más del 70% de la memoria. En estos 43 nodos la memoria pasó de 128 GiB a 256 GiB. Se aprovechó la parada total para hacer una actualización de software completa. «Uncorrectable ECC» En febrero …

Ago 16 2023

HPC: inversión y soberanía

Federico Stasyszyn y Dante Paz, miembros del Directorio del CCAD, participaron en una entrevista en el podcast “El Bestiario de Internet”, de Fundación Vía Libre, y conversaron acerca de la importancia y dificultades de lograr una soberanía de cómputo. Durante una distendida charla, Federico Stasyszyn y Dante Paz, miembros del Directorio del Centro de Computación …

Jul 07 2023

El CCAD en una competencia Internacional

Un equipo integrado por miembros del CCAD, estudiantes de la Facultad de Matemática, Astronomía y Física (FaMAF, UNC) y de la Facultad de Ingeniería (UCC), fue admitido para formar parte de la IndySCC. La IndySCC es un evento que comparte los objetivos del SCC pero con énfasis en educación e inclusión, dirigido especialmente para equipos …